在科技飞速发展的时代,半导体行业始终是焦点所在。AI 芯片领域更是犹如战场,各大厂商你争我夺。

近日,AMD 推出新款芯片 MI325X,并随之更新了 AI 芯片路线图,这一举措在业内引发了强烈反响。与此同时,人们广泛热议,AMD是否能够向英伟达的领导地位发起有力挑战?AMD 又能从这场激烈的竞争中攫取多少胜利的果实?除了AMD,英伟达需要面临的挑战还有哪些?

在此之前,一起了解一下AMD的新款芯片MI325X带来哪些亮点?以及其最新的AI芯片路线图又透露了何种信息。

01 MI325X,能否与B200掰手腕?

AMD最新推出的Instinct MI325X AI加速器,在大获成功的MI300X基础上再进一步,着重增强了HBM内存部分。

在AMD的表述中,主要将其与英伟达前代产品H200进行对比,而在今年3月,英伟达发布了其新款AI芯片B200。至于AMD这款新品与英伟达的H200相比有哪些亮点,这款产品有没有能力与英伟达的最新GPU B200掰掰手腕?

为了对比更为详尽,本文再次将这几款产品进行对比。

AMD最新推出的Instinct MI325X AI加速器采用了AMD CDNA 3 GPU架构,内置1530亿个晶体管,配备256GB下一代HBM3E高带宽内存,提供6TB/s的内存带宽。此外,MI325X在FP8和FP16精度下分别达到2.6 PF和1.3 PF的峰值理论性能。

作为对比,英伟达3月发布的基于Blackwell架构的B200 GPU基于台积电的N4P制程工艺,拥有高达2080亿的晶体管数量和192GB的HBM3e内存容量,提供了8TB/s的内存带宽,以及20PF的FP8峰值性能。

英伟达B200 GPU的AI运算性能在FP8及新的FP6上都可达20 PF,是前一代Hopper构架的H100运算性能8 PF的2.5倍。在新的FP4格式上更可达到40 PF,是前一代Hopper构架GPU运算性能8 PF的5倍。

从工艺制程上来看,MI325X未作披露,而B200采用上文所述的台积电N4P制程工艺。

从晶体管数量来看,英伟达B200此数值两倍于AMD MI325X。

从内存角度来看,AMD MI325X有着更高的内存容量,这可能使其在某些AI模型的推理性能上表现出色,但其带宽低于英伟达B200的8 TB/s。

从FP8峰值性能来看,英伟达B200以20 PF的FP8峰值性能脱颖而出。虽然在浮点运算能力上,B200 整体上要优于 MI325,但 MI325 的性能也足以满足大多数人工智能和高性能计算的需求。

从量产时间来看,两者的量产时间较为接近。AMD MI325X预计在2024年第四季度正式投产,2025年一季度开始向客户交付。英伟达的B200芯片原计划于今年晚些时候正式出货,然而由于Blackwell产能问题影响,其新款Blackwell B200芯片将延迟发布三个月或更长时间,批量出货或延迟至明年*季度。

总体而言,AMD MI325X与英伟达B200相比,仍存在显著差距。不过,与英伟达的前代产品H200 相比,MI325X的数据参数已有了大幅提升。

AMD数据显示,MI325X与英伟达H200的集成平台H200 HGX对比,MI325X平台提供1.8倍的内存量、1.3倍的内存带宽和1.3倍的算力水平。苏姿丰还表示,在运行Meta的Llama 3.1大模型时,MI325X的推理性能比H200高出40%。

02 未来AI芯片路线图,再度更新

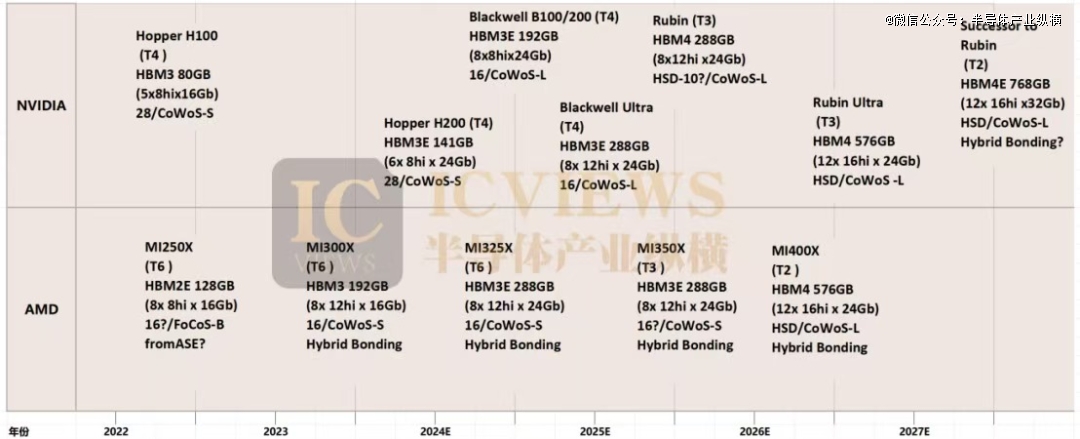

除了芯片的发布,AMD还公布了最新的AI芯片路线图。

AMD的AI芯片布局

AMD Instinct MI350系列*产品即Instinct MI355X,将引入新一代的CDNA 4架构,采用3nm工艺制造,搭配HBM3E,总容量进一步提升到288GB,对应带宽提高到8TB/s,TDP也上升到1000W,计划2025年下半年开始发货。

按照AMD的说法,Instinct MI355X提供了2.3PF的FP16和4.6PF的FP8计算性能,相比前代产品的提升幅度约为77%。此外,新产品还将支持新的数据类型,包括FP4和FP6。

另外,基于下一代AMD CDNA“Next”架构的AMD Instinct MI400 系列预计将于 2026 年上市。

英伟达的AI芯片布局

沿着规划的AI蓝图,英伟达加速前行,接下来将一年就更新一代产品,以往通常是两年更新一代。

今年6月,英伟达CEO黄仁勋带来了最新的AI芯片路线图。

眼下,Blackwell架构的GPU产品正在生产中,将成为2024、2025年的重要营收驱动。

接下来,英伟达计划发布一个增强版Blackwell Ultra GPU(8S HBM3e 12H),预计将于2025年推出。这款芯片将拥有 8 堆叠 HBM3e 内存,每叠有 12 个die高。B100 中的叠层大概是 8 堆叠,因此这应该代表 Blackwell Ultra 上的 HBM 内存容量至少增加 50%,甚至可能更多,具体取决于所使用的 DRAM 容量。HBM3E 内存的时钟速度也可能更高。

下一代Rubin GPU(8S HBM4)和相应的平台将于2026 年上市,这款芯片在此前的英伟达路线图中曾被称为 X100,Rubin GPU 将使用 HBM4 内存,并将有 8 个堆栈,大概每个堆栈都有 12 个 DRAM。

随后于2027 年的 Rubin Ultra GPU 将有 12 个 HBM4 内存堆栈,并且可能还有更高的堆栈。

为了有更直观的对比,可以仔细查阅下图:

那么,从技术路线图的角度进行观察,AMD 与英伟达在发展进程上似乎并没有太大的差距。然而,在实际应用场景当中,这两家企业之间的较量究竟呈现出怎样一番景象呢?当产品真正投入到各种应用场景中时,无论是在游戏体验、专业图形处理,还是在人工智能等相关领域,AMD 和英伟达的产品会各自发挥出怎样的性能?

03 较量之下,英伟达依旧是*赢家

过去数年间,英伟达在数据中心GPU市场中占据了主导地位,几乎构成了垄断,而AMD则长期稳居次席。

根据今年年初富国银行的统计,英伟达目前在数据中心AI市场拥有98%的市场份额,而AMD仅有1.2%的市场份额,英特尔则只有不到1%。

近日,根据摩根士丹利分析师发布的报告称,英伟达Blackwell GPU未来12个月的产能已经被预定一空。这意味着现在下订单的新买家必须等到明年年底才能收到货。摩根士丹利的分析师 Joseph Moore在给客户的一份报告中指出,英伟达的传统客户(AWS、CoreWeave、Google、Meta、Microsoft 和Oracle等)已经购买了英伟达及其合作伙伴台积电在未来几个季度将能够生产的所有 Blackwell GPU。

如此压倒性的需求可能表明,尽管来自AMD、Intel、云服务提供商(自研AI芯片)和各种小型公司的竞争加剧,但英伟达明年的AI芯片市场份额将会进一步增长。

不过,AMD并没有因此沮丧。AMD在与英伟达的竞争中,长期将自身看作“市场的多一种选择”。苏姿丰此前表示,AI芯片市场足够大,容得下多家企业,“AMD不是必须要打败英伟达才能成功”。

市场研究机构Moor Insights&Strategy首席分析师帕特里克·莫尔黑德(Patrick Moorhead)表示,“AMD面临的*挑战是获得企业市场份额。AMD需要在销售和营销方面投入更多资金,以加速其企业增长。”

从当前AI市场竞争格局来看,尽管 AMD 新款 GPU 较以往有所进步,但业界分析师认为,AMD 的技术至少落后英伟达一年。

不过,根据美国投资银行和金融服务公司KeyBanc分析师约翰・温(John Vinh)的分析,他认为今年AMD MI300X AI 加速卡的出货量将突破 50 万张。该分析师认为在数据中心领域,英伟达虽然一骑绝尘,AMD难以望其项背,但是 Instinct MI300X 凭借着*的实力,极高的性价比,成为行业客户的重要备选方案,包括联想在内的部分公司都认可 MI300X,这最终为 AMD 带来了更多的业务。

在近日的芯片发布会上,AMD 还强调了与甲骨文、谷歌、微软、Meta 等厂商的合作关系,苏姿丰称,微软、OpenAI、Meta、Cohere 等多个厂商的生成式 AI 平台已采用 MI300系列驱动。

至于英伟达究竟有何优势,以及基于哪些条件使其在 AI 盛行的时代脱颖而出,主要有以下几点。

04 两者对比,差距在哪里?

*,英伟达的 AI 芯片本身性能就十分强悍。从架构设计上来看,英伟达的 AI 芯片采用了高度优化的架构;在浮点运算能力方面,英伟达的 AI 芯片表现*。浮点运算能力是衡量芯片处理能力的关键指标之一;英伟达的芯片还具备出色的并行处理能力。AI 计算任务通常具有高度并行化的特点,英伟达的 AI 芯片通过集成大量的计算单元,能够同时处理多个数据块。这种并行处理能力可以让芯片在处理 AI 任务时充分利用数据的并行性,进一步提高计算效率;在内存带宽和缓存设计上,英伟达也有独特的优势。

除了强悍的芯片性能,英伟达在以下几个方面的努力也多有裨益。

第二,在研发投入方面,英伟达向来不惜 “血本”。据悉,英伟达在截至七月份的季度中录得30.90亿美元的研发费用。将这一数字按年计算,这家GPU制造商一年的累计研发费用约 123.6 亿美元。

相比之下,AMD 在其截至6月底的季度中录得15.93亿美元的研发费用。将这一数字按年计算,该公司一年的累计研发费用为 63.72 亿美元。换句话说,根据目前的年化预测,英伟达目前的研发投入是AMD的2倍。

其实在发展初期,英伟达就非常重视研发生产力。2005年,AMD 的研发费用为11亿美元,是英伟达的3.2倍左右;而到了2022年,英伟达的研发费用就达到73.4亿美元,是AMD的1.47倍。截至整个2024财年(2023年自然年),英伟达研发费用高达86.75亿美元,是AMD同期研发费用的1.48倍。

过去10年(2014-2023自然年),英伟达累计投入费用高达364亿美元,高于苹果公司、微软公司等科技巨头。随着研发投入的不断增长,英伟达通过技术进步降低成本和产品价格,不断推出新的产品吸引更多消费者,优势自然也逐渐凸显。

第三,在生态布局方面,英伟达下手也颇早。英伟达推出CUDA平台,使得利用GPU来训练神经网络等高算力模型的难度大大降低,将GPU的应用从3D游戏和图像处理拓展到科学计算、大数据处理、机器学习等领域,这一生态系统的建立让很多开发者依赖于CUDA,进一步增加了英伟达的竞争壁垒。

如今AMD在抢占市场份额时遇到的*难题,就在于英伟达利用自家CUDA平台,已在AI软件开发领域建立起一条护城河,把不少开发人员牢牢绑定在了英伟达的生态系统里。作为应对,AMD一直在不断优化名为ROCm的软件,目的就是让AI开发人员能更轻松地把更多AI模型“搬”到AMD的芯片上。目前,ROCm的最新版本6.2,相较于旧版在推理和训练上都有了超过2倍的提升。

第四,英伟达凭借早期与台积电的紧密合作,得以在先进制程的获取上抢占先机。在芯片制造中,先进制程工艺能够显著提升芯片的性能表现。英伟达与台积电长期稳定的合作关系,使其在芯片生产的供应链管理上更加成熟。这种成熟体现在生产计划的精确安排、生产周期的有效控制以及产品良率的保障上。英伟达可以根据市场需求预测,合理安排芯片的生产计划,确保产品能够及时供应市场,满足客户需求。同时,在生产过程中,较高的产品良率意味着更低的生产成本和更高的生产效率。

相比之下,AMD 在争取台积电先进制程产能时,往往受到英伟达订单的挤压,在生产计划和良率控制方面可能面临更多的不确定性,这在一定程度上影响了 AMD 产品的市场竞争力和供货稳定性,进而导致其在 AI 芯片市场份额争夺中处于劣势。

05 结语

综上所述,英伟达在研发投入、生态布局、生产制造以及芯片性能等方面都展现出强大的实力,这使其在当前的 AI 芯片市场中占据了*的主导地位。然而,AMD 并非毫无机会。尽管目前 AMD 在这些关键领域相较于英伟达处于劣势,但它正在积极地做出改变和追赶。

随着 AI 市场的不断扩大和技术的持续迭代,未来充满了变数。十年之后的AI芯片市场将呈现何种竞争格局,还未曾可知。

【本文由投资界合作伙伴微信公众号:半导体产业纵横授权发布,本平台仅提供信息存储服务。】如有任何疑问,请联系(editor@zero2ipo.com.cn)投资界处理。