“大模型尺寸之争正在加速……倒退!”

OpenAI的GPT-4o mini一登场,又登上了大模型话题榜榜首。

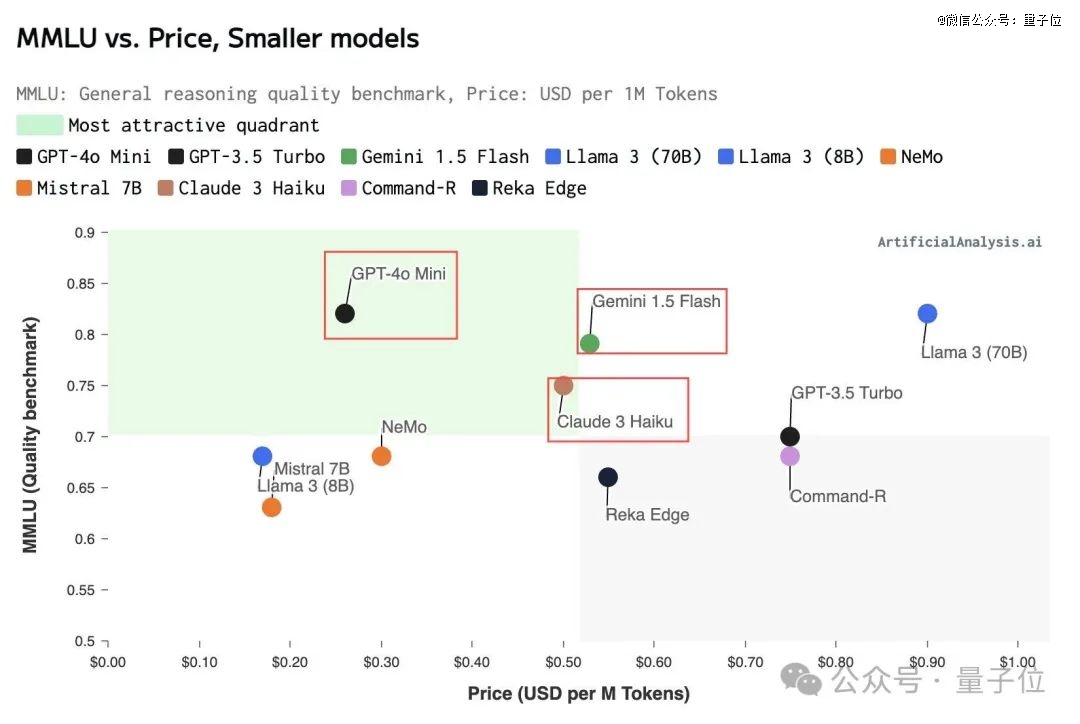

并且这次话题焦点,是OpenAI不仅再树新标杆,还一出手就把性价比卷爆了——直接把此前大受开发者好评的Gemini 1.5 Flash和Claude 3 Haiku给碾压了。

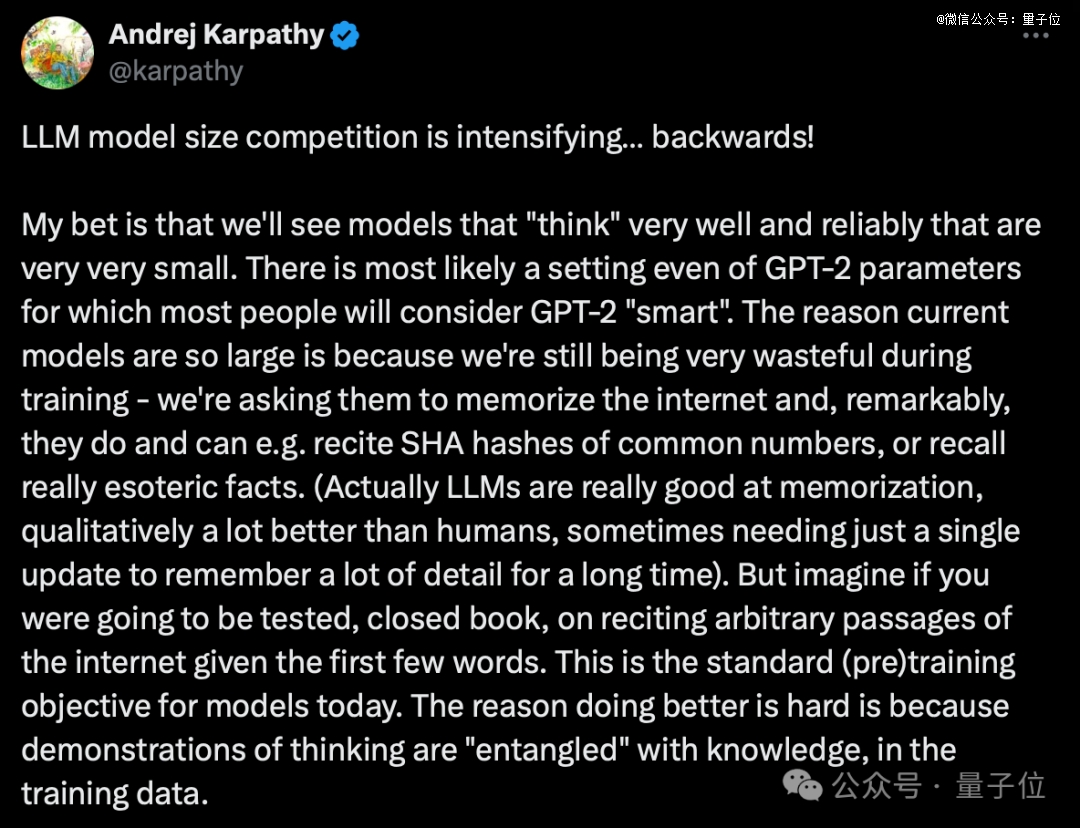

这不,大神Karpathy火速发了篇小作文,做出开头提到的这么一句判断,并进一步解释:

我敢打赌,我们会看到能够可靠“思考”的“小”模型,它们的参数量甚至可能只有GPT-2那么大。

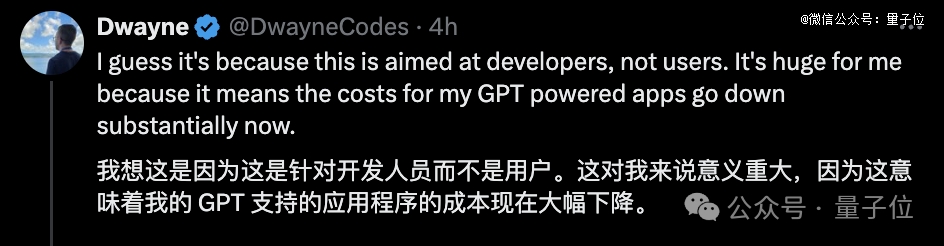

总之,开发者们的心情be like:

两年内大模型成本直降99%,今天宜当开发者。

锣鼓喧天的热烈讨论中,GPT-4o mini背后团队也没藏着掖着,都在𝕏上卖力宣传了起来,并不吝对自家“杀手级团队”的自豪。

也再度引来外界对OpenAI人才的关注。

我们扒了扒,发现其中依然不乏华人面孔。

半数Leader是华人

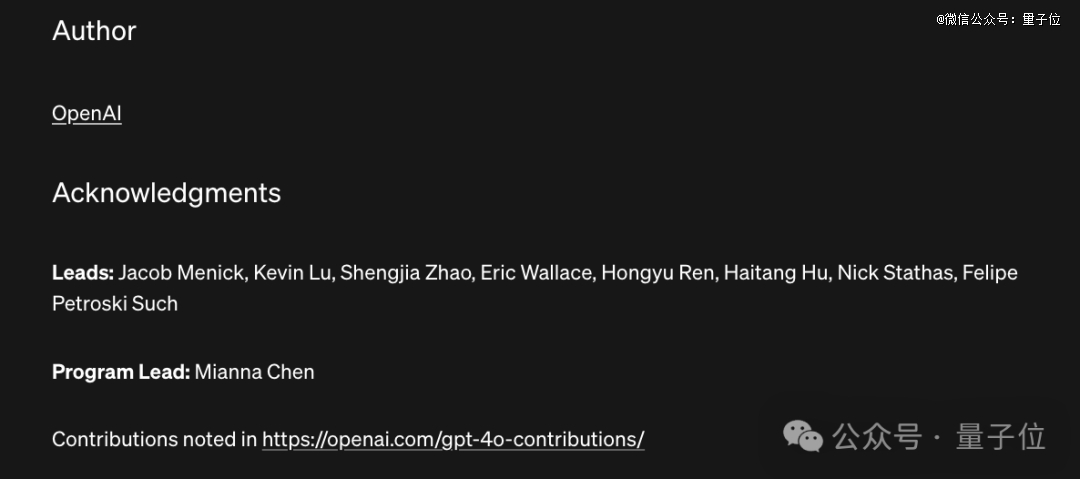

OpenAI照例在博客末尾附上了团队负责人名单。

此番9位负责人中,有5位都是华人面孔。

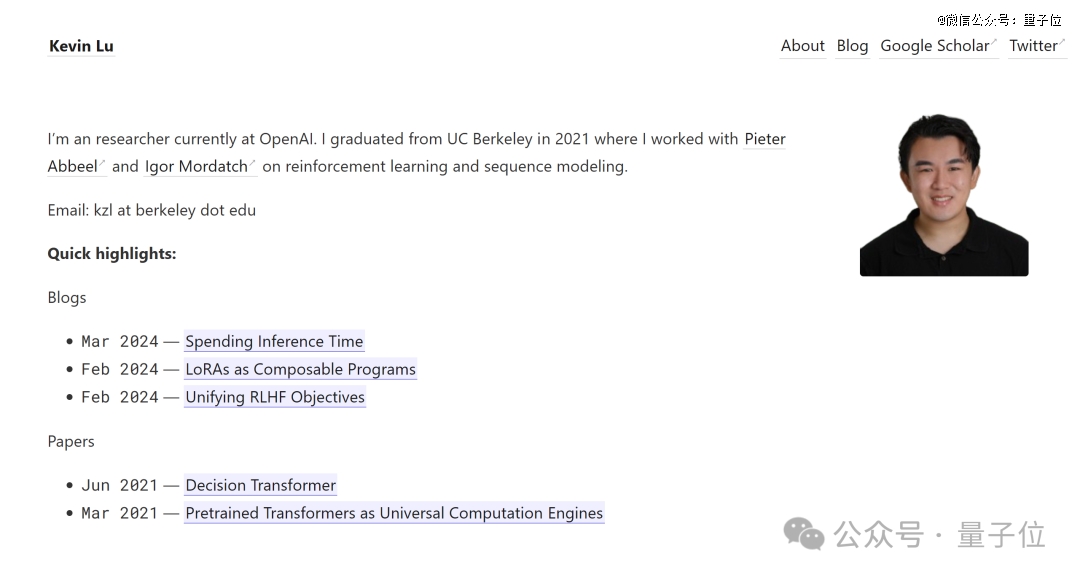

Kevin Lu,自述最近刚加入OpenAI。2021年毕业于加州大学伯克利分校,就读期间受伯克利人工智能研究所(BAIR)联合主任Pieter Abbeel和谷歌DeepMind研究科学家Igor Mordatch指导,研究方向是强化学习和序列建模。

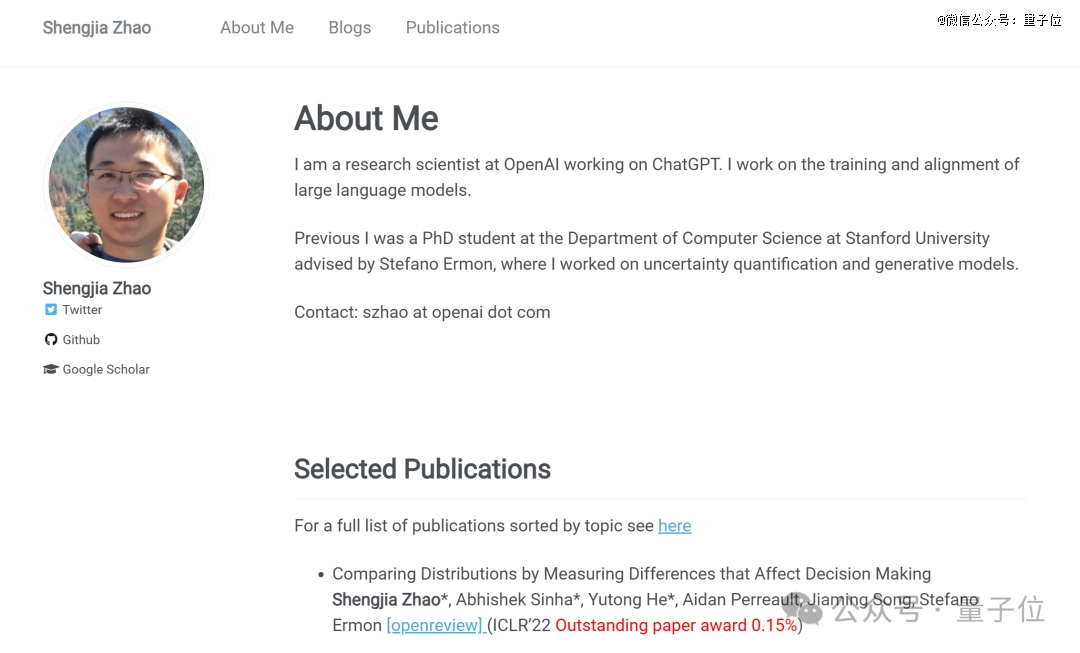

Shengjia Zhao,OpenAI研究科学家,方向为ChatGPT的训练和对齐。他于2022年加入OpenAI,博士毕业于斯坦福大学计算机科学系,本科毕业于清华大学。

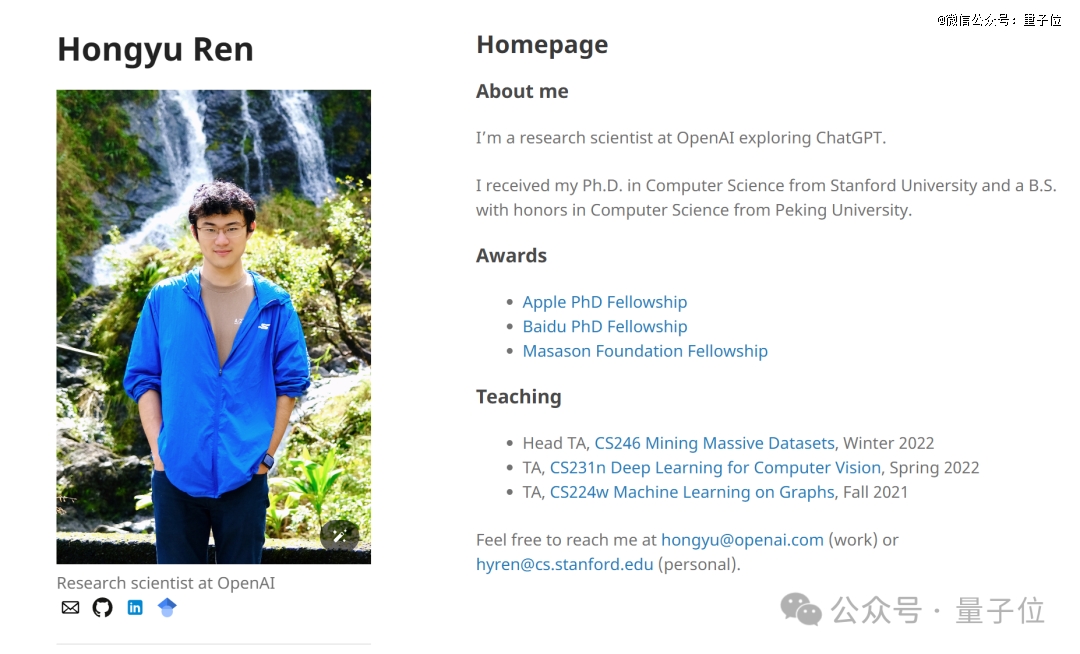

任泓宇,去年加入OpenAI担任研究科学家,主要负责语言模型训练。他也是GPT-4o的核心开发者、GPT-Next项目组成员。

任泓宇本科毕业于北京大学,博士毕业于斯坦福大学。加入OpenAI之前,他在Apple、Google、NVIDIA 和Microsoft均有大量研究实习经历。

Haitang Hu,去年9月加入OpenAI。他在2011年本科毕业于同济大学计算机专业,后赴约翰·霍普金斯大学攻读计算机硕士。

加入OpenAI前,他在Google工作了7年多。参与过TensorFlow以及大语言模型基础设施的研发工作。

项目经理Mianna Chen,也是GPT-4o的项目经理。她于2023年12月加入OpenAI,之前在Google和DeepMind担任产品经理。她毕业于普林斯顿大学,也是沃顿商学院的MBA。

除了以上几位华人面孔,GPT-4o mini团队还有其他几位核心成员。

Jacob Menick,2022年9月加入OpenAI担任研究员,是GPT-4o mini的技术总负责人。

他还曾共同参与领导了GPT-4o预训练工作,以及ChatGPT 浏览功能和机器学习工具使用的开发,在 2023 年 4 月和 5 月期间负责旗舰模型的后训练工作。

在加入OpenAI前,他在DeepMind干了6年多,参与了Gopher、RETRO和Flamingo等主要语言模型项目,并为DeepMind多模态大模型铺平了道路。

Eric Wallace,去年11月加入OpenAI担任研究员,致力于大模型更可靠、安全和强大。

目前他还在加州大学伯克利分校读博,研究方向是增强机器学习的安全性/隐私性/鲁棒性。在加入OpenAI之前,他还在DeepMind和Meta实习过。

Nick Stathas,去年5月加入OpenAI,拥有高性能计算、机器学习、自动驾驶车辆和嵌入式系统等领域的经验。他本硕均就读于麻省理工学院,曾在MIT Driverless兼职首席工程师,负责无人驾驶汽车的自动驾驶软件开发。

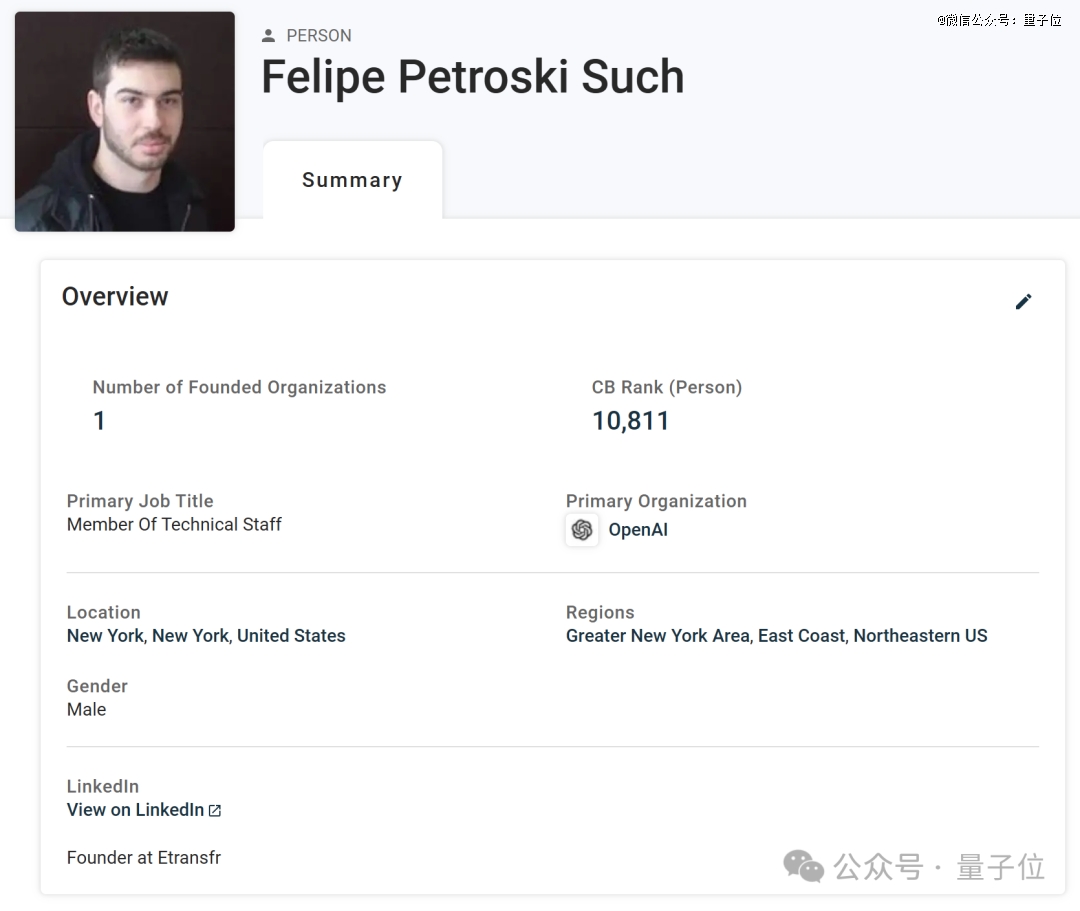

Felipe Petroski Such,GPT-4o mini团队中最早加入(2020年)OpenAI的人,也是GPT-4o的核心贡献者。

在加入OpenAI之前,他还在Uber担任了3年多研究科学家。再往前,他就读于罗切斯特理工学院,获得了计算机工程双学位,并在担任研究助理期间,专注于深度学习研究,包括文档分类、分割和智能字符识别。

mini速度到底有多快

说完了背后的人,回到GPT-4o mini本身,总结一下这波就是主打一个又快又便宜,要在开发者面前找回场子。

那么除了数据之外,最后,我们也不妨来实测一波它到底能有多快。

先直观感受一波速度:

(滑屏速度快赶不上生成速度了)

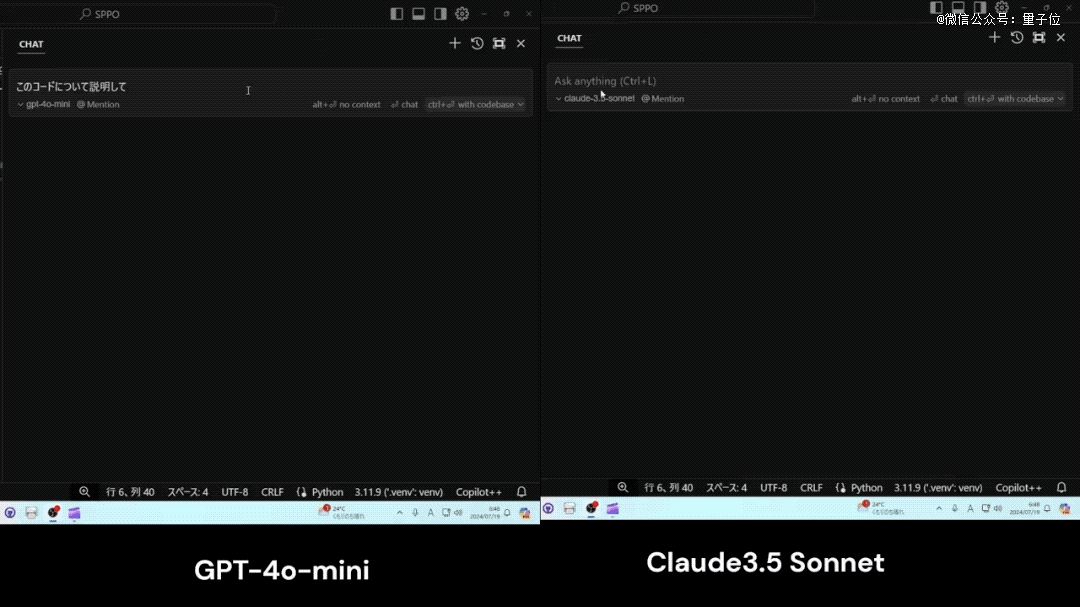

还有网友把GPT-4o mini和另一位当红炸子鸡Claude 3.5 Sonnet放在Cursor上,来了场1v1。

另外,在面对长文本生成需求时,GPT-4o mini的16k输出长度确实比Claude 3.5 Sonnet的8k输出长度更好用。

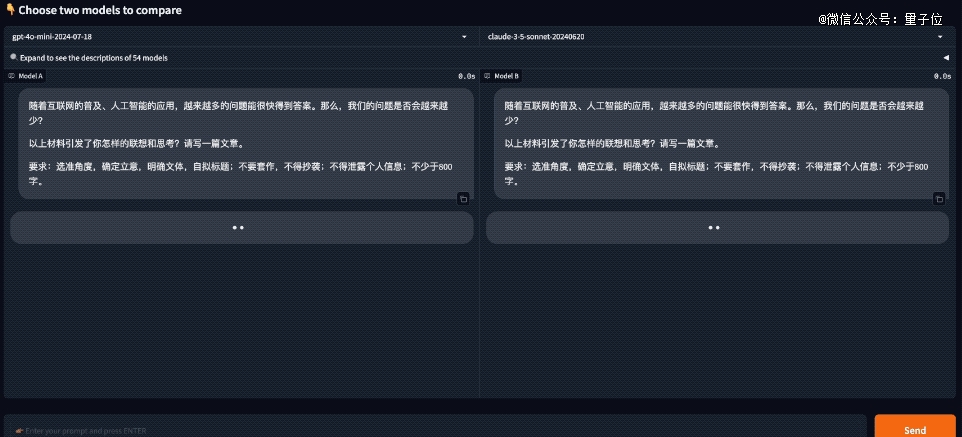

比如做这道800字的高考作文题,相比于GPT-4o mini的库库输出,Claude同学“总之”刚写了半句就停下了,最后也没写完这篇作文。

正如网友所说,1.09元人民币/百万输入tokens、4.36元人民币/百万输出token的价格,基本上就是Claude 3 Haiku价格的一半,GPT-4o mini能有这表现,还要啥自行车。

毕竟,这可能一下子就让某些产品告别亏钱走向盈利了(doge)。

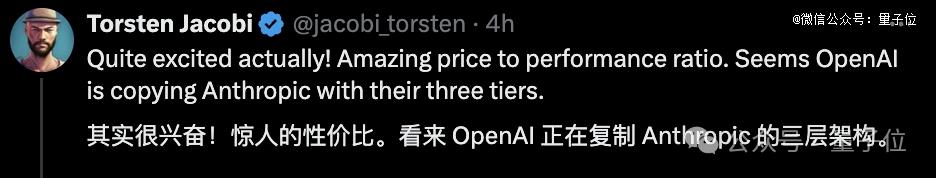

不过,也有人不买账:

一旦Gemini 2 Flash或者Claude 3.5 Haiku发布,GPT-4o mini就没看头了。

还有网友干脆阴阳怪气了起来:

还是那个问题:GPT-5呢?

参考链接:

[1]https://openai.com/index/gpt-4o-mini-advancing-cost-efficient-intelligence/

[2]https://x.com/karpathy/status/1814038096218083497

【本文由投资界合作伙伴微信公众号:量子位授权发布,本平台仅提供信息存储服务。】如有任何疑问,请联系(editor@zero2ipo.com.cn)投资界处理。